← Zurück zum Blog · Zur Übersicht

GAN auf dem Teleskop

Eine KI-Schicht über Livebildern vom Nachthimmel – zwischen „Rausch weg!“ und „UFO-Alarm!“

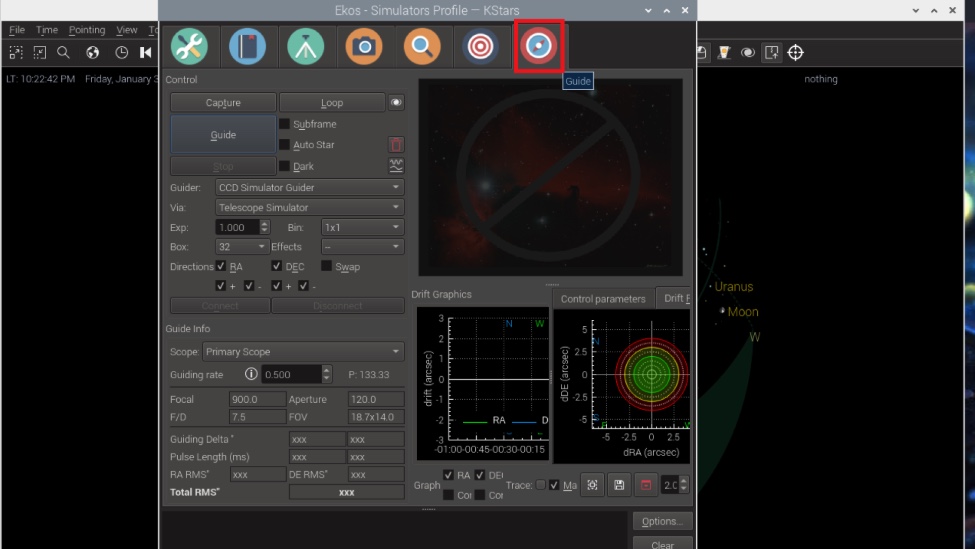

Astroberry.

Worum geht’s?

Die Grundidee ist einfach (und dadurch natürlich gefährlich): Das Teleskop liefert Livebilder, ein kleiner Rechner (z. B. Raspberry Pi mit Astroberry) nimmt sie entgegen – und ein vortrainiertes GAN verarbeitet die Frames in Echtzeit oder „nahe Echtzeit“.

Ich will damit eine Art KI-Overlay bauen: eine zusätzliche Schicht, die Rauschen reduziert, Strukturen hervorhebt oder – wenn ich gerade schlechte Entscheidungen treffe – das Universum „künstlerisch neu interpretiert“.

Mögliche Anwendungsfälle

- Rauschunterdrückung bei schwachen Deep-Sky-Objekten (Photonen sind scheu).

- Feature-Erkennung (z. B. Galaxienformen, Nebelstrukturen, „Moment mal…“).

- Kreative Visualisierung als Live-Overlay bei Beobachtungs-Sessions.

Technischer Plan

Aktuell experimentiere ich mit der Frage, welches Modell auf welcher Hardware überhaupt praktikabel ist, ohne dass das System unbenutzbar langsam wird. Parallel schaue ich mir an, wie man GAN-Ergebnisse mit klassischen Stacking-Workflows aus der Astrofotografie kombinieren kann: erst sauber stacken – dann optional KI-Glitzer.

Reality-Check: Dinge, die (natürlich) passiert sind

Schon in den ersten Tests hat meine KI eine sehr klare Meinung entwickelt: Satelliten sind Fremdkörper. Nicht im Sinne von „Objekt im Bild“, sondern im Sinne von „UFO mit Absicht“.

Ich: „Das ist Starlink.“

KI: „Unbekanntes Objekt. Verdächtig. Alien-Score 0.92.“

Ich: „Bitte sag mir, dass du keine interstellare Meldung rausgeschickt hast.“

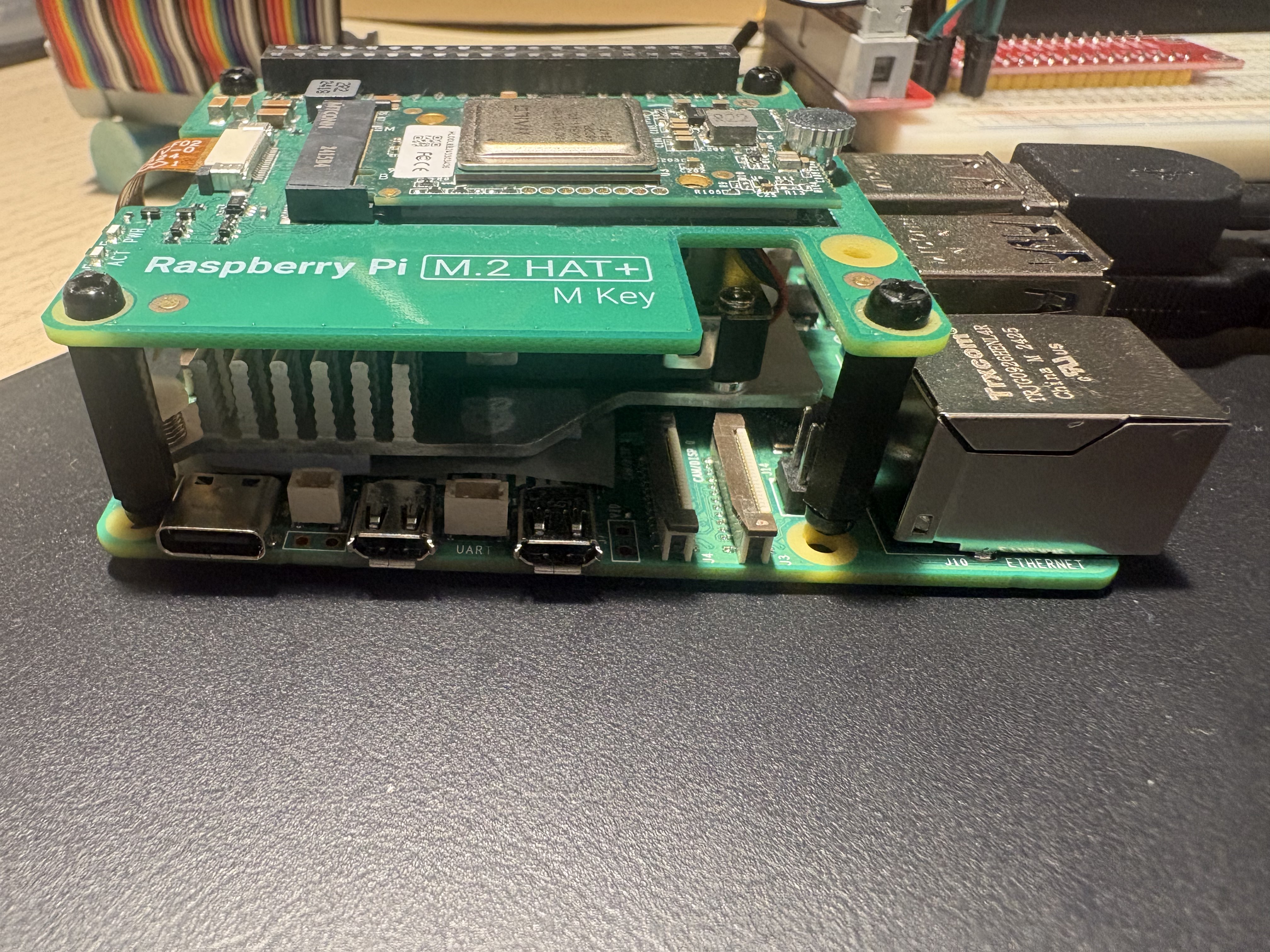

Und dann war da mein Kühl-Experiment. Ich dachte: „Ich kühle den Raspberry im Kühlschrank, dann bleibt er stabil.“ Ergebnis: Kondenswasser + Elektronik = Kurzschluss-Kunstinstallation. Der Raspberry hat danach entschieden, dass er lieber ein Briefbeschwerer ist.

Platzhalterbild: Raspberry Pi. Diesmal ganz und sogar mit neuronalen Netzen on top.

Außerdem habe ich versucht, ~30 GB öffentliche ESA/NASA-Bilddaten durch ein GAN zu jagen – auf einem Raspberry Pi mit 8 GB RAM. Das ist ungefähr so, als würdest du versuchen, einen Wal durch einen Strohhalm zu schieben… während der Strohhalm nebenbei Python ausführt.

Weitere „glorreiche“ Zwischenfälle (zu eurer Unterhaltung)

- „Nur kurz“ die Auflösung hochdrehen → plötzlich läuft alles in Zeitlupe (1 FPS und ein Gebet).

- Falscher Ordner → eine Stunde Training auf fast schwarzen Frames. Ergebnis: ein GAN, das exzellent… Schwarz generiert.

- Overlay leicht versetzt → Nebel links, Sterne rechts. Ich war kurz überzeugt, ich hätte Raumzeit gekrümmt.

- „Das ist bestimmt ein neuer Nebel!“ → es war eine Fingerkuppe auf der Linse. Wissenschaftlich sehr menschlich.

- „Ich mache das kurz ohne Abschirmung gegen Streulicht“ → mein Setup misst hauptsächlich: Wohnzimmer.

Was als Nächstes kommt

- Stabiler Pipeline-Prototyp (Frame rein → preprocess → GAN → Overlay raus).

- Klare Trennung zwischen „wissenschaftlich sinnvoll“ und „kreativ lustig“.

- Satelliten/Flugzeuge als „nicht-astronomisch“ markieren (damit die KI nicht jedes Mal UFO-Party feiert).

- Hardware-Realismus: Was geht wirklich auf einem Pi, was braucht ein größeres System?

Wenn du Ideen hast, welche Modelle auf kleiner Hardware realistisch sind – oder wie man Satelliten zuverlässig erkennt/ausblendet – schreib mir gern. Und ja: Ich nehme auch „hör auf, deinen Raspberry zu kühlen“ als valide Empfehlung.

Hinweis: Hobby-/Experimentierprojekt. Keine Garantie, dass die KI nicht aus Versehen eine Galaxie „optimiert“, bis sie aussieht wie ein Emoji.